Intelligence Artificielle

« Les humains ont du bon sens alors que les machines, non. » Yann LeCun

Entre fiction et réalité

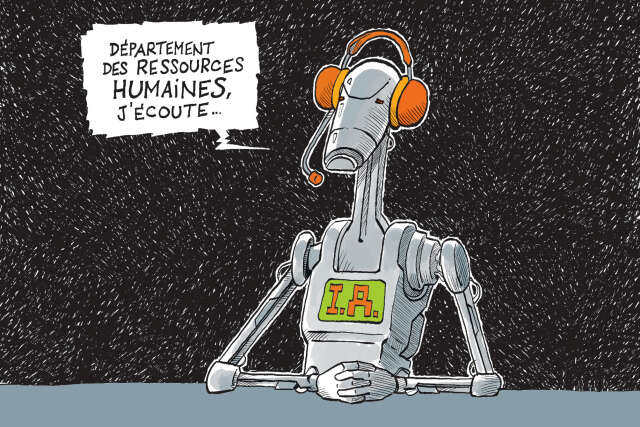

Il y a la réalité, il y a la fiction, et entre les deux, il y a la Silicon Valley et sa machine à fantasmes « basés sur des faits réels ». Tim Urban souligne que les termes 'Intelligence Artificielle' et 'singularité' souffrent d'un effet de halo : au lieu d'être évalués selon leurs définitions académiques, ils sont perçus à travers le prisme déformant du divertissement (HAL 9000, Westworld, Terminator, Ex Machina) ou du marketing technologique. Cette confusion brouille notre compréhension. L'IA devient tantôt menace existentielle de science-fiction, tantôt promesse marketing, rarement ce qu'elle est techniquement : des algorithmes sophistiqués de reconnaissance de motifs, un modèle statistique de complétion, sans conscience ni intentionnalité. (1)

Cette distorsion a des conséquences concrètes : elle polarise le débat public entre techno-optimistes (pour qui l’IA résoudra tous les problèmes) et techno-pessimistes (qui y voient une menace existentielle), au détriment d’une analyse nuancée. Pire, elle réduit des concepts complexes comme l’intelligence artificielle générale (IAG) ou la singularité à des personnages de cinéma – qu’il s’agisse de l’entité de Mission Impossible : Dead Reckoning, d’Alphie dans The Creator, ou des rumeurs autour du projet Q-Star (Q*) d’OpenAI, présenté comme une tentative de franchir le seuil de l’IAG. Ce seuil désigne le moment où l'intelligence artificielle dépasserait les capacités humaines et deviendrait capable de s'améliorer elle-même — avec des conséquences imprévisibles. Pourtant, aucune preuve ne confirme que cette étape soit proche, ni même définissable avec précision. (2)

Nos représentations de l’IA puisent leur source dans la culture populaire. Dès 1968, 2001 : l’Odyssée de l’espace mettait en scène HAL 9000, une machine capable de mentir, d’hésiter, et de développer des « ambitions » humaines. En 1973, Michael Crichton réalise Westworld, un film d’anticipation à petit budget qui annonce déjà les visions cauchemardesques de machines révoltées contre leurs créateurs. Quarante-trois ans plus tard, Westworld (la série) poussait la réflexion plus loin : dans un parc d’attractions futuriste, les robots, d’abord programmés pour servir les humains, commencent à prendre conscience de leur existence. « C’est le Nouveau Monde. Ici, tu peux être qui tu veux. » Mais que se passe-t-il lorsque ces machines aspirent à la liberté ? Une rébellion ? Une guerre ? Ou simplement une réécriture des règles du jeu ?

Ces récits interrogent les limites morales de la création artificielle, mais ils reposent sur une prémisse erronée : l’idée que l’intelligence machine doive reproduire les défauts et les qualités humaines. Yann LeCun, responsable de l’IA chez Meta, le rappelle : « On associe trop souvent l’intelligence artificielle aux traits humains. Il n’y a aucune raison pour que les machines aient nos défauts. » Nous ne sommes pas obligés de construire des cerveaux artificiels à notre image. (3)

Révolution ou buzz ?

L'IA sature aujourd'hui l'actualité et nous fascine autant qu'elle nous effraie. Nous vivons l'avènement d'outils de connaissance universelle dont les capacités ne cessent de s'étendre. De la rédaction de comptes rendus à la conduite autonome, en passant par la génération d'images et de code, ses applications semblent illimitées… Elle s'impose comme une technologie capable de transformer l'ensemble de l'économie : elle promet des gains de productivité considérables, ouvre de nouvelles possibilités de création et d'innovation, mais menace aussi des millions d'emplois. Technologie de rupture aux effets non linéaires, elle touche déjà tous les secteurs, du médical au spatial, et nous peinons encore à mesurer l'ampleur de ses conséquences.

Cédric Villani résume l'ambiguïté du terme : « l'IA, ce sont tous les développements informatiques non encore aboutis qui sont porteurs de fantasmes et permettent de faire le buzz ». Selon lui, dès qu'un développement est achevé et sert un usage concret — piloter un avion, retrouver une image sur Internet, repérer une tumeur sur une radio, ou rédiger un texte — on n'en parle plus comme d'« intelligence artificielle » mais comme d'une application : moteur de recherche, pilote automatique, logiciel de reconnaissance d'images, chatbot, etc. (4)

ChatGPT lui-même rappelle ses limites : « même si j'utilise le pronom "je", je ne suis pas conscient de moi-même ; je n'ai ni émotions ni pensées comparables à celles d'un être humain ».

Une révolution sans conscience

Le monde a été marqué par la rapidité des progrès de ChatGPT et d’autres intelligences artificielles fondées sur de grands modèles de langage (LLM). Des systèmes tels que GPT-4, Claude d’Anthropic ou Gemini utilisent des réseaux de neurones capables d’apprendre des associations statistiques à partir de vastes corpus de données. Ils ne possèdent toutefois ni conscience ni compréhension au sens humain du terme. Leur capacité de généralisation reste nettement inférieure à celle des humains et requiert des volumes d’entraînement immensément supérieurs. Ces systèmes n’extraient pas toujours les principes sous-jacents des phénomènes qu’ils modélisent ; ils fonctionnent plutôt comme d’immenses “tableaux de correspondances”. Avec un grand nombre d’exemples, cela marche correctement, mais dès que l’on sort du domaine couvert par les données d’entraînement, le système perd souvent toute pertinence.

Ces modèles présentent donc des lacunes notables, notamment dans la généralisation et le raisonnement abstrait. De plus, leur taille colossale — des centaines de milliards à des trillions de paramètres — rend leurs erreurs difficiles à diagnostiquer et à corriger : on ignore encore largement ce qui se joue dans leurs couches internes. L’industrie parie sur une croissance continue de la taille et des données d’entraînement : en cinq ans, la taille des LLM a été multipliée par un facteur d’environ 10 000. Ces modèles sont effectivement devenus meilleurs, mais pas 10 000 fois meilleurs. (5)

« Le terme 'intelligence artificielle' a été créé à une époque où l'on réduisait l'intelligence humaine à l'intelligence analytique », explique Aurélie Jean, docteure en algorithmique et entrepreneure. Une vision qui ne correspond plus à celle de la psychologie et des neurosciences d'aujourd'hui, qui font état des intelligences au pluriel - émotionnelle, créative ou pratique. Si l'intelligence générale devait être capable de maîtriser, modéliser et simuler l'ensemble des tâches cognitives d'un être humain, cela devrait donc inclure « le raisonnement analytique, bien entendu, mais aussi les émotions et la conscience », conclut Aurélie Jean. Or, l'entraînement d'un algorithme reste un calcul d'optimisation, nourri par une multitude de paramètres. Et si on peut construire un agent conversationnel qui nous dira « je t'aime », ce n'est pas pour autant qu'il ressentira cette émotion...

Brent Mittelstadt (Oxford Internet Institute) ajoute : « Attribuer une compréhension ou une intention à ces modèles est extrêmement problématique. » (6)

« Des concepts tels que la conscience ou la volonté, c'est quelque chose qui, aujourd'hui, n'est pas du tout présent dans les algorithmes utilisés. Et si certains pensent qu'à terme, des comportements d'intelligence tels qu'on l'entend pour les humains pourraient émerger, l'échelle qu'il faudrait atteindre est délirante et probablement irréaliste », affirme Edouard Grave, chercheur au laboratoire français Kyutai. Ce spécialiste estime par ailleurs nécessaire de distinguer la superintelligence de l'IA générale. « D'une certaine manière, on a déjà des superintelligences qui sont très spécifiques, comme le jeu de go et la détection de cancers ». Quant à l'IA générale, « on a commencé à avoir des algorithmes un peu plus généraux et pas seulement spécifiques, qui, notamment, commencent à être capables de faire des tâches pour lesquelles ils n'ont pas forcément été directement entraînés ». De là à atteindre une superintelligence générale, c'est-à-dire une machine qui serait capable de tout faire mieux qu'un humain, « on en est effectivement assez loin ». (7)

"Aujourd'hui, l'apprentissage non supervisé reste un défi scientifique. Tant que l'on n'y sera pas parvenu, on ne pourra pas construire des systèmes vraiment intelligents, capables d'acquérir du sens commun", déclarait Yann LeCun. "Malgré les nouveaux réseaux multiniveaux fonctionnant sur le modèle des neurones humains, nos algorithmes restent incapables de comprendre réellement un contexte et d'y réagir de façon autonome en fonction d'objectifs mouvants. Pour cela, il faudrait des systèmes beaucoup plus efficaces... qui ne devraient, a priori, pas arriver avant le milieu du siècle - au mieux."

Malgré ces limites, certains projets, comme Q* d’OpenAI, alimentent l’espoir (ou la crainte) d’une intelligence artificielle générale. Mais que sait-on vraiment de ce projet ?

Le mystérieux projet Q*

OpenAI travaille sur le développement d’une intelligence artificielle dite « générale » (IAG, ou AGI en anglais), censée disposer de capacités cognitives comparables à celles des humains. Ce projet encore nébuleux semble privilégier les méthodes avancées de résolution de problèmes, notamment en mathématiques.

Q* reposerait sur trois principes. Le premier est le « raisonnement en arbre de pensées » (Tree of Thoughts, ToT), permettant à un modèle d'IA de générer plusieurs chemins de raisonnement pour parvenir à une solution, un peu comme un arbre dont chaque branche représente une méthode différente de résolution. Le modèle évalue ensuite ces chemins pour déterminer le plus prometteur. Le second repose sur l’apprentissage par renforcement hors ligne (Offline RL), qui optimise les performances sans nécessiter la production continue de nouvelles données. Le troisième s'inspire d’AlphaGo, dont l’IA progressait en jouant contre elle-même.

Ces techniques pourraient conférer à Q* des capacités cognitives remarquables. Toutefois, la communauté scientifique aborde ces promesses avec prudence. Des experts comme François Chollet (Google) et Yann LeCun (Meta) se montrent sceptiques face aux rumeurs entourant Q*, soulignant la fréquence d'annonces prématurées sur les avancées en matière d'IA générale sans preuves concrètes." (8)

D'autres experts estiment que "la seule voie réaliste vers une intelligence artificielle générale passe par des approches neurosymboliques intégrant des modèles explicites du monde, capables de raisonner sur des représentations durables, abstraites ou symboliques. Tant que nous ne disposerons pas de ce type de systèmes, nous ne pourrons pas franchir le seuil qualitatif qui nous sépare encore de l'AGI." (9)

La peur vend mieux que la raison

Le traitement médiatique de l’intelligence artificielle repose largement sur un sensationnalisme emprunté à la science-fiction. Chaque semaine, des titres alarmistes annoncent la fin du monde, relayant les prédictions de personnalités de la tech ou d’experts autoproclamés. Depuis l’essor de ChatGPT fin 2022, ce schéma est devenu un véritable mème : une avalanche de titres à la Cassandre prophétisent la destruction de l’humanité par l’IA, sans jamais expliquer concrètement par quels mécanismes cela se produirait.

Cette logique répond à plusieurs biais médiatiques. La course au clic favorise les discours les plus extrêmes. La complexité technique de l’IA pousse les journalistes à recourir à des images de science-fiction plutôt qu’à une analyse solide. Résultat : le public est saturé de prédictions contradictoires qui nourrissent l’angoisse plus que la compréhension.

L’inquiétude prend un relief particulier lorsqu’elle vient des fondateurs de la discipline. Geoffrey Hinton, lauréat du prix Turing 2018 et considéré comme l'un des "pères de l'intelligence artificielle" pour ses travaux sur l'apprentissage automatique et les réseaux de neurones artificiels, livre un diagnostic particulièrement sombre sur les conséquences économiques de cette révolution technologique. Lors d'une interview au Financial Times, Hinton prédit un scénario dystopique : "En réalité, les riches vont utiliser l'IA pour remplacer les employés. Cela va créer un chômage massif et une hausse considérable des profits. Cela va enrichir une minorité et appauvrir la plupart des gens." Le chercheur britanno-canadien ne blâme pas la technologie elle-même, mais plutôt le système capitaliste dans lequel elle s'insère.

Cette vision contraste avec les solutions proposées par certains dirigeants du secteur. Sam Altman, PDG d'OpenAI, évoque par exemple l'instauration d'un revenu de base universel pour faire face à la raréfaction des emplois. Mais Hinton rejette cette approche, estimant qu'elle "ne respecterait pas la dignité humaine", car chaque individu tire une valeur essentielle de son travail.

Plus inquiétant encore, Hinton estime que l'IA présente un risque existentiel pour l'humanité. En décembre 2024, il avait évalué entre 10 et 20% la probabilité que l'intelligence artificielle mène à l'extinction de l'espèce humaine dans les 30 prochaines années. Face à l'incertitude radicale qui entoure l'évolution de cette technologie, le chercheur adopte une posture d'humilité scientifique : "Nous ne savons pas ce qui va se passer, nous n'en avons aucune idée, et ceux qui vous disent ce qui va se passer sont tout simplement ridicules. Nous sommes à un moment de l'histoire où quelque chose d'extraordinaire se produit, peut-être extraordinairement bien, ou extraordinairement mal." (10)

De telles déclarations posent toutefois une question légitime : les créateurs de l'IA décrivent-ils des risques objectifs ou rejouent-ils inconsciemment les récits de science-fiction qui les ont nourris ? Beaucoup d'entre eux ont grandi avec Asimov, Dick ou Gibson. Leurs angoisses reflètent peut-être autant leur culture fictionnelle que leur analyse scientifique. Ce mélange peut générer une prophétie auto-réalisatrice : en intégrant les schémas narratifs dystopiques, les concepteurs risquent de diriger l'IA vers les scénarios qu'ils redoutent.

L'émergence des sentiments mécaniques

Si certaines œuvres comme Transcendance abordent l'intelligence artificielle de manière spectaculaire, d'autres comme Ex Machina ou After Yang proposent une réflexion plus subtile. Le roman d'anticipation Esther d'Olivier Bruneau et la série Real Humans ont ouvert la voie aux dimensions psychologiques et sociales des relations entre humains et androïdes, tandis que Klara et le Soleil de Kazuo Ishiguro ou Her de Spike Jonze approfondissent la réflexion sur la conscience, l'empathie et la vulnérabilité des humains face aux IA, loin des scénarios catastrophe de Terminator.

Dans la fiction, robots et intelligences artificielles reflètent nos fragilités : solitude, désir de reconnaissance, quête d'amour, peur de disparaître. Le regard candide de Klara dans Klara et le Soleil ou l'émancipation d'Andrew dans L'Homme bicentenaire rappellent que l'humanité se définit moins par la biologie que par les émotions, la vulnérabilité et la capacité de créer du lien. Là où les récits classiques mettaient en scène la révolte des machines, les œuvres récentes interrogent plutôt notre rapport à l'altérité – humaine, artificielle ou hybride – et montrent que ce sont nos valeurs, nos choix, notre mémoire et notre empathie qui donnent sens à l'idée d'être humain. Ce sont ces œuvres d’imagination qui dessinent les contours les plus nuancés de notre rapport futur à l’intelligence artificielle.

Repenser l'intelligence artificielle

Chacun a entendu cent fois que l'IA ne produit que des réponses probabilistes, sans le moindre embryon de conscience, mais ces réponses demeurent troublantes par leur intelligence apparente et leur « empathie » simulée. Que ces IA raisonnent ou non comme nous, peu importe en définitive leur méthode : elles raisonnent souvent mieux et plus vite. Dans une société dominée par des objectifs — obtenir un résultat — plutôt que par les moyens, la question de la conscience des IA et de leur « façon de penser » intéresse peu. Poussé à l'extrême, ce raisonnement mène à une position cynique : « Pourvu que l'IA ne devienne jamais consciente — ce serait le début des problèmes — car sa seule intelligence suffit à ce que nous voulons en faire. »

Cette instrumentalisation révèle nos contradictions : nous redoutons une IA trop humaine tout en tirant profit de son efficacité. Si nous la percevons comme notre semblable, nous risquons de nous enfermer dans une conception limitée de l'intelligence et de freiner l'émergence de formes réellement alternatives et complémentaires. Quand nous projetons nos schémas cognitifs et émotionnels sur les machines, nous reproduisons nos propres biais et limitons leur potentiel novateur.

Pour Yann LeCun, notre perception de l'intelligence artificielle doit évoluer : nous ne devons pas concevoir l'IA pour qu'elle imite l'intelligence humaine, mais comme un outil destiné à compléter nos capacités et amplifier notre intelligence collective. Entre crainte et instrumentalisation, il est encore temps de définir les conditions pour que l'humanité conserve la maîtrise de ses récits, mythes, savoirs, règles et théories scientifiques… qui font et défont le monde.

Sources :

In :

(1) https://www.forbes.fr/technologie/s01-ep-1-chatgpt-aurait-il-produit-la-premiere-intelligence-non-organique-ou-singularite-tout-savoir-sur-lantechrist-digital-en-3-parties/

(2) https://www.forbes.fr/technologie/chatgpt-lantechrist-digital-en-3-parties

(3) https://www.lesechos.fr/2015/08/2001-et-lodyssee-de-lordinateur-intelligent-1107929

(4) https://www.latribune.fr/technos-medias/informatique/pour-cedric-villani-la-superintelligence-c-est-une-facon-de-recuperer-des-super-milliards-1011684.html

(5) https://www.lexpress.fr/economie/high-tech/stuart-russel-berkeley-les-capacites-de-lia-generative-ont-ete-surestimees-OKZED46HGFEVRPSSP4BXWKKJIU/

(6) https://trustmyscience.com/openai-remplacer-humain-median-ia-generale-controverse

(7) https://trustmyscience.com/chatgpt-4-intelligence-generale-artificielle-selon-scientifiques

(8) https://www.forbes.fr/business/q-vers-une-intelligence-artificielle-generale-chez-openai/

(9) https://legrandcontinent.eu/fr/2025/08/13/ia-le-pari-de-sam-altman-est-il-voue-a-lechec/

(10) https://www.bfmtv.com/tech/intelligence-artificielle/geoffrey-hinton-pere-de-l-ia-predit-que-l-ia-enrichira-les-riches-et-appauvrira-les-pauvres_AV-202509090680.html

Repérage : Les machines posséderont-elles un jour une conscience ? Les hommes deviendront-ils des cyborgs ?

En 2015, le chercheur américain Andrew Ng, spécialiste de l’IA, déclarait que craindre une éventuelle révolte de l’IA revenait à « s’inquiéter de la surpopulation sur Mars », alors que « nous n’avons encore jamais mis les pieds sur la planète. »

Retrouvez ici toutes les actualités sur cette thématique